Dalam era teknologi dan internet yang semakin maju, kita sering mendengar tentang istilah “robots.txt.” Namun, bagi kebanyakan orang, istilah ini mungkin terdengar asing dan misterius. Apa sebenarnya robots.txt, dan apa fungsi serta cara kerjanya? Artikel ini akan menjelaskan semua hal tersebut.

Pengertian Robots.txt

robots.txt adalah sebuah file teks yang berfungsi sebagai protokol standar untuk mengontrol aktivitas perayapan (crawling) robot atau spider yang dilakukan oleh mesin pencari dan bot internet lainnya. File ini ditempatkan di akar (root) situs web dan memberi instruksi kepada robot tentang halaman mana yang diizinkan atau dilarang untuk diakses.

Dalam istilah sederhana, robots.txt bertindak sebagai peta jalan bagi bot web. Robot dari mesin pencari seperti Google, Bing, Yahoo, dan lainnya akan mengunjungi halaman ini sebelum memulai proses crawling untuk memahami batasan-batasan situs web tersebut. Jika robots.txt tidak ada di situs web, bot web akan mengasumsikan bahwa semua halaman dapat diakses.

Fungsi Robots.txt

Pengaturan Akses

Fungsi utama dari robots.txt adalah mengatur hak akses bagi robot web. Dengan adanya file ini, pemilik situs dapat membatasi akses robot ke beberapa bagian situs yang mungkin tidak ingin diindeks atau ditampilkan dalam hasil pencarian.

Efisiensi Crawl

Dengan memberikan instruksi yang jelas pada robots.txt, situs web dapat membantu mengarahkan bot web untuk memfokuskan crawl pada halaman-halaman yang dianggap lebih relevan atau penting. Hal ini dapat membantu menghemat sumber daya dan waktu robot dan memastikan situs Anda diindeks dengan lebih efisien.

Perlindungan Data

Beberapa bagian situs web mungkin berisi informasi sensitif atau data pribadi yang tidak boleh diakses oleh bot web. Dengan menggunakan robots.txt, Anda dapat mencegah informasi sensitif ini dari akses yang tidak diinginkan.

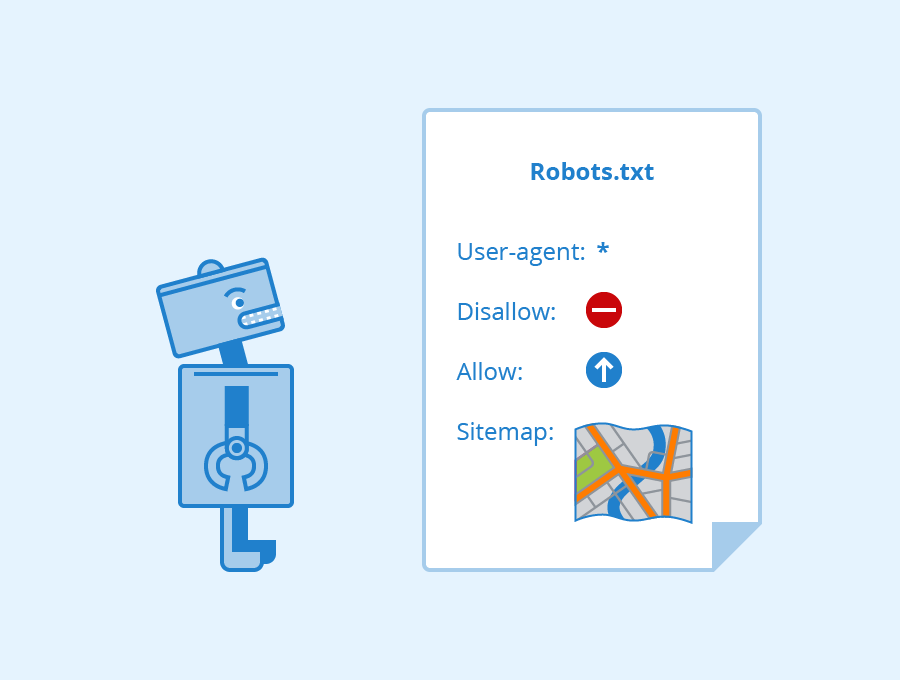

Cara Kerja Robots.txt

Proses kerja robots.txt relatif sederhana. Ketika bot web dari mesin pencari atau entitas lain mengunjungi sebuah situs web, langkah-langkah berikut terjadi:

Mengakses robots.txt: Bot web akan mencari file robots.txt di direktori utama situs web dengan mengunjungi http://namadomainanda.com/robots.txt.

Setelah file ditemukan, bot web akan membaca isinya untuk memahami instruksi yang diberikan. File ini dapat berisi beberapa perintah, termasuk instruksi untuk akses penuh atau akses terbatas ke halaman-halaman tertentu.

Bot web akan mengikuti perintah yang tercantum dalam robots.txt. Jika ada halaman yang diizinkan untuk diakses, bot akan memulai proses crawling di halaman tersebut. Sebaliknya, jika ada halaman yang dilarang untuk diakses, bot akan menghindari halaman tersebut dalam proses crawlingnya.

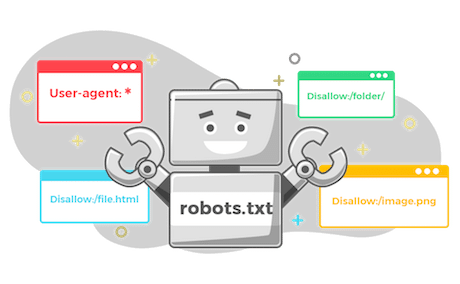

Contoh robots.txt

Berikut adalah contoh sederhana file robots.txt:

User-agent: *

Disallow: /admin/

Disallow: /private/

Dalam contoh ini, file robots.txt memberi perintah kepada semua bot web (User-agent: *) untuk tidak mengakses halaman dengan URL yang dimulai dengan /admin/ atau /private/.

Kesimpulan

Robots.txt adalah instruksi teks yang penting dalam dunia internet yang mengontrol aktivitas perayapan oleh bot web. Dengan memanfaatkan robots.txt dengan bijaksana, Anda dapat mengatur hak akses dan efisiensi crawl di situs web Anda, serta melindungi informasi sensitif dari akses yang tidak diinginkan. Semoga penjelasan di atas membantu Anda memahami pentingnya robots.txt dan bagaimana cara kerjanya.

Jika ada kendala atau pertanyaan, Anda dapat dengan mudah menghubungi kami melalui live chat atau open ticket. Semoga artikel ini bermanfaat!